Le chef adjoint de l’Unité Innovation de l’OTAN nous présente les travaux que l’Organisation mène actuellement en vue d’élaborer sa politique en matière d’intelligence artificielle.

Comme nous l’avions fait observer dans le premier article de cette série sur l’innovation à l’OTAN, l’Alliance est engagée dans une course mondiale à l’adoption des nouvelles technologies, que des puissances rivales exploitent d’ores et déjà dans un double objectif : accroître leur compétitivité économique et développer leurs capacités militaires. Dans cette course aux technologies émergentes et aux technologies de rupture, les Alliés sont face à une série de défis s’articulant autour de deux axes interdépendants : faire en sorte que ces technologies soient adoptées de manière dynamique, et en assurer une gouvernance responsable. Au cœur de ces considérations figure l’intelligence artificielle.

L’intelligence artificielle (IA) est la capacité d’une machine à effectuer des tâches qui nécessiteraient normalement une intelligence humaine – par exemple reconnaître des formes, apprendre de manière empirique, tirer des conclusions, faire des prévisions ou réaliser une action –, que ce soit pour un système purement numérique ou en tant que logiciel de commande d’un système physique autonome (voir le rapport Science & Technology Trends 2020-2040 – Exploring the S&T Edge).

Comme le suggère le think tank RAND dans son rapport sur la posture du département américain de la Défense en matière d’intelligence artificielle (évaluation et recommandations), paru en 2019, il est utile de distinguer pour l’IA trois grands types d’applications : administratives, soutien de la mission, et opérationnelles.

L’IA administrative englobe les applications telles que les systèmes de gestion financière ou de gestion du personnel ; elles sont déployées dans des environnements étroitement contrôlés, où les répercussions d’une panne technique (en termes de danger immédiat et de létalité potentielle) sont limitées.

L’IA opérationnelle, en revanche, a vocation à être déployée dans le cadre de missions et d’opérations, c’est-à-dire dans des environnements nettement moins contrôlés, où les conséquences d’une panne pourraient être catastrophiques. Il s’agit par exemple des logiciels de pilotage de systèmes stationnaires ou de drones.

L’IA en soutien de la mission est quant à elle une catégorie intermédiaire en termes de contrôle de l’environnement et de retombées d’une panne. Elle recouvre un ensemble varié d’applications telles que la logistique, la maintenance, le renseignement, etc.

Compte tenu des différents niveaux de risque inhérents à ces catégories, cette classification peut être utile pour définir les priorités relatives aux politiques d’adoption de l’IA ou aux principes devant régir son utilisation responsable.

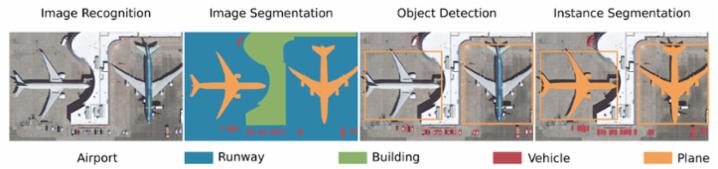

L’IA actuelle, dite de deuxième vague, repose sur l’apprentissage automatique, une technique qui consiste à développer et à appliquer des algorithmes statistiques pour relever des tendances dans les données. On peut par exemple, à l’aide d’un large jeu de données correctement étiquetées, entraîner un algorithme de classification à déterminer à quelle catégorie rencontrée précédemment appartient un nouvel objet. L’apprentissage profond est un sous-ensemble de l’apprentissage automatique qui vise à résoudre des problèmes de prévision ou de reconnaissance de formes lourds en calculs à l’aide de réseaux neuronaux artificiels multicouches. Les réseaux neuronaux convolutifs, par exemple, servent pour la détection d’objets dans des images. Comme on peut le voir sur l’illustration ci-dessous, l’apprentissage profond s’utilise notamment pour l’identification d’avions, de véhicules et de bâtiments au sein d’images.

L’apprentissage profond s’utilise notamment pour la détection d’objets spécifiques au sein d’images.

(Source : Hoeser T., Kuenzer C., Object Detection and Image Segmentation with Deep Learning on Earth Observation Data: A Review-Part I: Evolution and Recent Trends. Remote Sensing, 2020, 12, 1667.)

L’apprentissage automatique convient particulièrement lorsqu’on dispose de grands ensembles de données exactes, mais fonctionne mal avec des données peu précises ou en quantité insuffisante. Dans de bonnes conditions, ses performances, en termes de qualité des prévisions et bien entendu de vitesse, sont supérieures à celles de l’homme dans un nombre grandissant de tâches étroitement ciblées de prévision et de reconnaissance de formes, principale raison à son adoption croissante dans de vastes pans de l’activité humaine.

S’engager sur la voie de l’adoption dynamique

Traditionnellement, les économistes modélisent la production comme une fonction du travail et du capital (les facteurs de production), et des intrants matériels. S’agissant de l’IA, les facteurs de production sont une main-d’œuvre hautement qualifiée et spécialisée et l’infrastructure informatique utilisée pour le calcul et le stockage, tandis que les données forment le principal intrant.

Cela revient-il à dire que la donnée est le nouveau pétrole ? En substance, non. S’il est effectivement nécessaire de « l’extraire » et de la « raffiner » pour pouvoir l’utiliser, à l’inverse du pétrole, plus on en produit, plus elle est disponible. La donnée est par ailleurs spécifique, et non fongible : chaque usage nécessite un jeu spécifique de données capturant des observations du monde réel (ou des simulations) parfaitement pertinentes. Pour bénéficier d’une base solide dans ce domaine, les institutions de défense des Alliés doivent donc continuer d’avancer sur la voie du numérique et prendre en compte, dans leurs politiques en matière de données, l’ensemble de la chaîne de valeur relative à celles-ci, de la collecte aux modalités d’accès en passant par le partage, le stockage, les métadonnées, la documentation, le contrôle de la qualité (y compris le nettoyage des données et l’atténuation des biais) et les processus visant à assurer le respect des exigences légales.

Il convient également d’optimiser les facteurs de production (ici la main-d’œuvre et l’infrastructure) en prévoyant des politiques de ressources humaines et de passation de marchés adéquates et flexibles, afin d’attirer et de conserver les professionnels les plus qualifiés, ainsi qu’en déployant des capacités de calcul et de stockage adaptées et sécurisées.

Vient ensuite la productivité. Les acteurs économiques ont toujours recherché les meilleurs moyens de combiner les facteurs de production : sont-ils complémentaires ? Substituables ? Quelle combinaison offre les rendements les plus élevés ? Quels processus et pratiques de production et de gestion donnent les meilleurs résultats ? S’agissant de l’IA, il y a certes quelques arbitrages à faire, mais les facteurs de production sont nettement plus complémentaires que substituables : pour réussir, il faut investir de manière substantielle dans les trois facteurs.

Pour ce qui est des processus et de la gestion, les bonnes pratiques du secteur du logiciel nous apprennent que le développement et la fourniture de solutions faisant appel à l’IA doivent obéir à la méthodologie Agile plutôt qu’au traditionnel modèle en cascade (waterfall). Cette approche repose sur des processus itératifs et hautement dynamiques ayant comme point de départ un énoncé de problématique malléable plutôt qu’un énoncé des besoins détaillé et rigide. La méthode Agile se décline en plusieurs variantes suivant les secteurs d’activité, et certaines d’entre elles sont activement utilisées dans des communautés OTAN.

S’engager à une utilisation responsable

Pour réussir son passage à l’IA, l’Alliance va en outre avoir besoin de nouveaux principes et pratiques, bien conçus, régissant la gouvernance et l’emploi de celle-ci. Certains gouvernements des pays de l'Alliance ont déjà pris en matière d’utilisation responsable de l’intelligence artificielle des engagements publics abordant des concepts tels que, entre autres, la légalité, la responsabilité, la fiabilité ou encore la gouvernabilité.

Des Alliés ont par ailleurs pris part, sous les auspices des Nations Unies, au Groupe d’experts gouvernementaux sur les systèmes d’armes létaux autonomes, qui a formulé 11 principes directeurs ayant trait à cette problématique.

Notons qu’il y a de bonnes raisons de considérer les travaux sur l’adoption de l’IA et ceux sur les principes d’utilisation responsable comme complémentaires et synergiques : en effet, certains principes et objectifs fondamentaux sous-tendent et facilitent à la fois la définition de bonnes pratiques et l’adoption de comportements responsables par les États.

Certains principes adoptés par les pays ont des incidences spécifiques en termes d’exigences de conception : du principe de gouvernabilité, par exemple, peut découler une nécessité de prévoir des capacités techniques visant à détecter et à éviter des conséquences imprévues et à annuler l’action ou à désactiver le système en cas de comportement aberrant.

Il faudra nécessairement mettre en œuvre et tester les caractéristiques techniques requises pour que ces objectifs, et d’autres, soient atteints. Ce travail d’ingénierie sera lui-même l’occasion d’acquérir de nouvelles connaissances, ce qui permettra, en retour, d’affiner et de faire mûrir les principes existants. Il sera essentiel d’avancer dans les domaines des essais, évaluations, vérifications et validations (TEVV) et de s’appuyer sur des travaux de modélisation et de simulation pertinents. Les compétences éprouvées de l’OTAN dans le domaine de la normalisation permettront d’encadrer utilement ces axes d’effort tout en favorisant l’interopérabilité entre les forces des pays de l’Alliance.

D’ici là, les principes généraux tels que ceux établis par certaines autorités nationales ou sous les auspices de l’ONU peuvent servir de base à de nouvelles consultations entre Alliés ainsi que de points de référence concernant les positions actuelles des pays.

Cet article est le deuxième d’une mini-série dans laquelle l’Unité Innovation de l’OTAN présente les technologies que les Alliés cherchent à adopter et les opportunités que celles-ci représentent pour la défense et la sécurité de l’Alliance.